写于托福考试前。

加神问我最近在看什么,我说《深度学习》。加神很惊讶:“就叫深度学习?这也太耿直了吧。”

我是怎么知道这本书的

一开始看见这本书是在朋友圈里。从杜克回来之后发现舍友也在看这本书。

如果上网搜各种机器学习的教程,也有类似的推荐。

久而久之,我就被安利了。

所以说朋友的力量很重要daze!

我的感受

本书分为三个部分:数学基础、深度学习的实践、以及深度学习的研究前沿。

阅读这三个部分,我的心情如下:太简单了!可以理解!这什么鬼!

这本书的信息量是爆炸的,如果是第一次看,肯定看不完。说实话,那个正相负相分解的公式我配合着CD算法,看了n遍,才总算搞懂一点点负相的优化在哪里。

不过好在四月份的作业不多,我坚持每天看三十页书,好歹是看过一遍了。

第三部分真的是云里雾里。不过看过第二十章《深度生成模型》之后,再回过头看第三部分的前几章,会知道为什么要做这些“算配分函数”“近似推断”的事情。

正则化是我比较喜欢的一个章节,讲了我很多以前没接触过的东西。比如说BN(批标准化),比如说提前终止,还有一直听别人讲但是并不清楚是什么的Dropout。

可以说三位作者对于现在网络结构为什么成功的原因的分析是高屋建瓴的,我摘几个句子:

“卷积给网络带来了很强的先验:该层应该学得的函数只包含局部连接关系并且对平移具有等变性。同样地,池化也带来了很强的先验:每一个单元都具有对少量平移的不变性。” 这些先验在处理图像时带来了好处是图像正好满足这些先验,且图像的大部分信息包含在相邻像素之间的相对强弱,而非像素本身的强弱。另一个方面讲,这些先验很强,可能会带来网络本身的欠拟合。

万能近似定理表明,一个前馈神经网络如果具有线性输出层和至少一层具有任何一种 “挤压” 性质的激活函数(例如sigmoid激活函数)的隐藏层,只要给予网络足够数量的隐藏单元,它可以以任意的精度来近似任何从一个有限维空间到另一个有限维空间的 Borel可测函数。但另一方面,这个定理并不能保证我们能够训练出这样的函数。就比如过拟合,又比如优化函数太菜。

万能近似定理并没有告诉我们这个网络该有多大。但有结果表明,存在一些函数族能够在网络的深度大于某个值d时被高效地近似,而当深度被限制到小于或等于d时需要一个远远大于之前的模型。在很多情况下,浅层模型所需的隐藏单元的数量是n的指数级。这或许解释了我们为什么要用深度,因为深度可以带来对数级窄的网络。

另外一个使用深度的原因可能是:“选择深度模型默许了一个非常普遍的信念,那就是我们想要学得的函数应该涉及几个更加简单的函数的组合。这可以从表示学习的观点来解释,我们相信学习的问题包含发现一组潜在的变差因素,它们可以根据其他更简单的潜在的变差因素来描述。”

前几年周志华大佬说过,深度学习可能会过时,但机器学习不会。最近他这么说深度神经网络成功的原因:

有逐层的处理(不断地抽象)

有特征的内部变化(得到丰富的表示函数,特征空间会变)

有足够的模型复杂度(足够的容量,没有像如线性回归“学不下去了!”的绝望想法)

我觉得很有道理。特征的内部变化帮助神经网络自主选择表示方法,实现端到端的学习;逐层的处理使得每一层专注于简单的操作;足够的模型复杂度帮助网络适用于不同的任务与海量的数据。

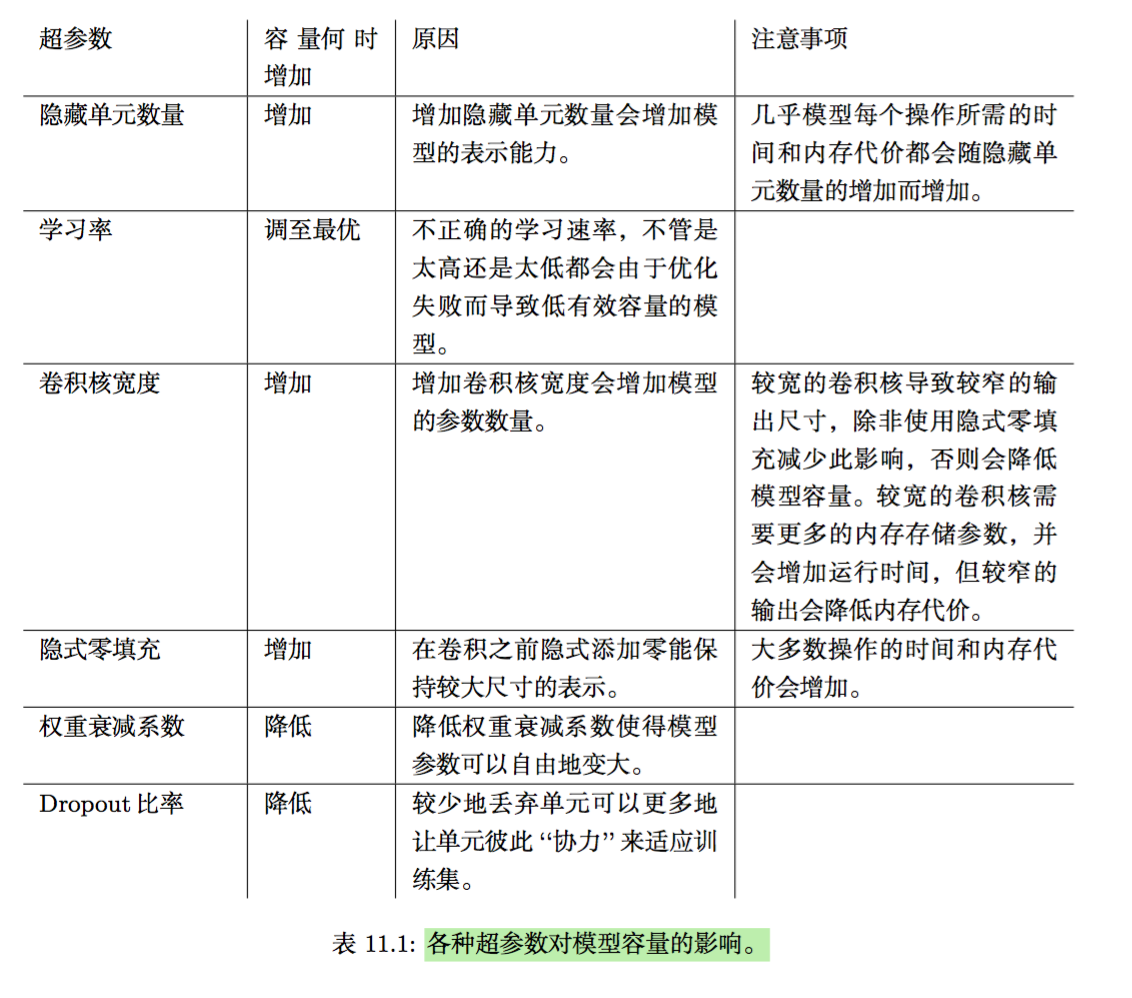

《实践方法论》的这张表真的是太棒了。

可以说第二部分值得反复观看,它是整本书对于进阶者最有实践意义。第三部分学习坡度太大,不建议观赏。(不过挺有意思的!)

学习过程中搜集到的网站

学习过程中碰到一些很不错的Tutorial,与各位分享。

Introduction to Restricted Boltzmann Machines

讲RBM的教程,有例子,方便理解。

-

复旦邱锡鹏老师开的神经网络课,讲义是中文写的。个人觉得写得比西瓜书精,也符合现在的潮流。

MCMC与重要采样

-

讲如何给HMM模型定参的。这位博主的高质量博文很多。同样的内容也推荐隐马尔可夫模型之Baum-Welch算法详解,内有海藻模型的举例。

心得

不求一次性搞懂,不然容易陷入深渊。但是碰到书中的一带而过的名词需要知道它是用来干嘛的。就比如说醒眠算法,书中描述它的篇幅很少,我以为不怎么重要。但其实在第二十章中训练DBN(深度信念网络)时,又重新提到了它。

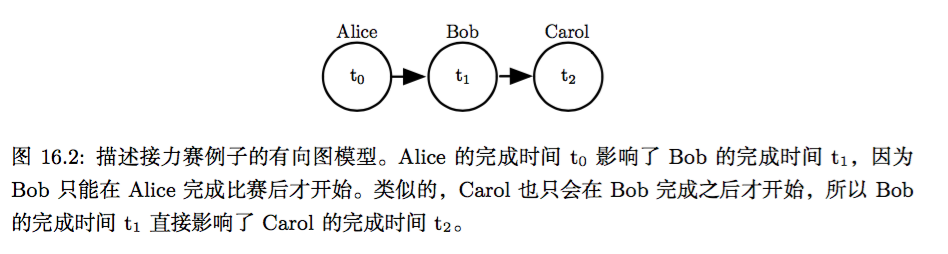

再比如说有向图和无向图的区别。这其实是在第十六章《深度学习中的结构化概率模型》中提到的东西,后面反复在强调它们之间的性质的区别,但如果不仔细看第十六章,我根本不知道它们的定义的区别。(好吧,我悄悄告诉你,它们定义的区别是有向图的因果关系很明确。就比如说A跑完步之后把接力棒传给B,那么B跑完步的接力总时间取决于A,因此A节点的边必然指向B节点,而不是反过来的方面。而对于无向图,潜变量与可观测变量之间的因果并不清楚。具体可以参考下图)

由于无向图的条件概率不是给定的,要算整个事件的概率必须通过团势能计算,且还要计算配分函数,而配分函数需要将所有事件发生的概率相加,计算量过于大,因此导致了之后第十八章《直面配分函数》以及第二十章中的解决方式。《近似推断》中提到使用变分方法近似后验概率,这也是VAE所采用的方法。

所以你可以看到,整本书是有逻辑的,而这个逻辑作者并不会耐心讲给你听。他写在干货贼多的句子里,等你去发掘。